Una reflexión crítica sobre los límites éticos del juicio clínico asistido por inteligencia artificial.

Un paciente masculino de 66 años, con enfermedad coronaria multivaso, disfunción ventricular severa e historia de cirugía de revascularización miocárdica, ingresó a un centro hospitalario del interior del país por disnea y angina atípica. La angiografía coronaria reveló oclusiones arteriales y fallo de injertos venosos, confirmando un cuadro clínico de alto riesgo. Ante la complejidad del caso, se organizó su evaluación por un equipo médico interdisciplinario con participación remota de los cirujanos cardiovasculares tratantes. Sin embargo, durante el intervalo entre la coronariografía y la reunión del equipo médico, el paciente y sus hijos introdujeron sus datos clínicos e imágenes en una aplicación de inteligencia artificial de libre acceso.

El algoritmo, sin validación clínica ni comprensión del contexto, emitió una advertencia categórica: “riesgo inminente de muerte súbita”. Esta notificación provocó una crisis de ansiedad aguda, con síntomas neurovegetativos, taquicardia, sensación de muerte inminente y descompensación emocional. Al día siguiente, fue evaluado en consulta ambulatoria, documentándose una arritmia ventricular no sostenida. El paciente recibió tratamiento médico estabilizador, evaluación psiquiátrica y acompañamiento emocional, tras lo cual pudo retomarse la evaluación integral con su equipo clínico.

Este caso, documentado y reflexionado en Instituto Educardio (1), no representa un error médico tradicional, sino una forma emergente de iatrogenia algorítmica, donde el daño no es producido por un fármaco o procedimiento invasivo, sino por la interpretación no acompañada y descontextualizada de un dictamen automatizado. El evento plantea preguntas cruciales: ¿Puede una herramienta de IA reemplazar el juicio clínico humano? ¿Qué riesgos implica delegar decisiones críticas en sistemas opacos y sin regulación? ¿Cómo proteger emocionalmente al paciente en entornos frágiles, sobreinformados y poco alfabetizados digitalmente?

En Venezuela, donde coexisten vocación médica, innovación aislada y graves limitaciones estructurales, la introducción de inteligencia artificial en cardiología intervencionista debe ir acompañada de marcos éticos, deliberativos y prudenciales. Desde herramientas que analizan electrocardiogramas hasta algoritmos que sugieren procedimientos coronarios o implantación de dispositivos, la IA está comenzando a participar activamente en decisiones de vida o muerte.

Este artículo propone una reflexión crítica desde la bioética clínica sobre la iatrogenia algorítmica, analizando su impacto en la práctica de la cardiología intervencionista venezolana a partir de este caso emblemático. A través de la integración de evidencia científica, análisis normativo y principios éticos universales como la no maleficencia, la autonomía, la justicia y la responsabilidad, buscamos contribuir al desarrollo de una medicina tecnológica, pero profundamente humana, donde los algoritmos no sustituyan al médico, sino fortalezcan su discernimiento en beneficio del paciente concreto.

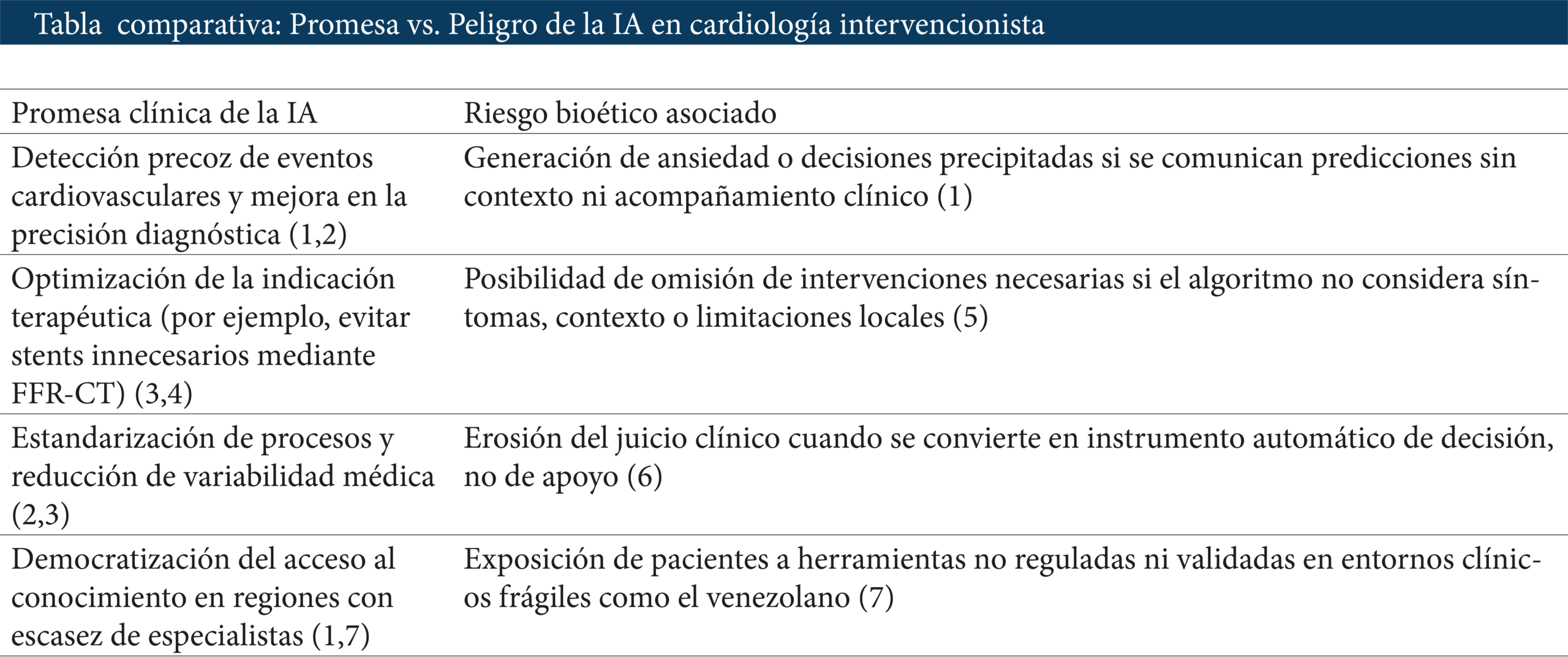

La promesa de la inteligencia artificial en cardiología

La inteligencia artificial (IA) representa una de las transformaciones más significativas de la medicina del siglo XXI. En cardiología, su aplicación ha generado grandes expectativas en torno a la optimización diagnóstica, la estratificación del riesgo cardiovascular, la planificación de intervenciones y la monitorización remota de pacientes crónicos (1,2). Esta revolución tecnológica ha sido impulsada por la creciente capacidad de los algoritmos para analizar grandes volúmenes de datos clínicos, electrocardiográficos, imagenológicos y genéticos, ofreciendo patrones de predicción más rápidos y, en muchos casos, más precisos que la evaluación tradicional.

En el campo específico de la cardiología intervencionista, la IA ya participa en varias etapas del proceso clínico: desde la detección precoz de isquemia miocárdica mediante electrocardiogramas interpretados automáticamente, hasta la planificación tridimensional de angioplastias complejas, pasando por la evaluación funcional no invasiva de estenosis coronarias a través de software como el FFR-CT o el angio-FFR (3,4).

Estas herramientas, cuando son validadas clínicamente, pueden contribuir a reducir procedimientos innecesarios, mejorar la eficiencia del flujo asistencial y estandarizar el criterio médico en entornos de alta presión y volumen, como ocurre en muchas salas de hemodinamia (5). Adicionalmente, el desarrollo de modelos de aprendizaje automático aplicados a historias clínicas electrónicas permite identificar pacientes con alto riesgo de eventos cardiovasculares mayores antes de que presenten síntomas evidentes (6).

En el contexto venezolano, donde el sistema público de salud se encuentra profundamente deteriorado y el acceso a tecnología avanzada es limitado y desigual, la IA representa una oportunidad ambivalente. Por un lado, puede democratizar parcialmente el conocimiento médico, especialmente a través de plataformas gratuitas o de bajo costo que asisten el diagnóstico en lugares donde no hay cardiólogos permanentes. Por otro lado, si estas herramientas se aplican sin regulación, sin validación local y sin supervisión profesional, pueden generar consecuencias adversas, amplificar desigualdades o sustituir indebidamente el juicio clínico (1,7).

En centros de referencia como los existentes en Mérida, donde aún se sostiene la cardiología intervencionista gracias al compromiso humano, académico y asistencial de sus profesionales, la implementación prudente de IA puede constituir un apoyo valioso. Sin embargo, dicha implementación debe ser crítica, progresiva y centrada en el paciente y no en el algoritmo. La tecnología, por sí sola, no basta.

Por ello, aunque la IA representa una promesa concreta para la cardiología moderna —y una herramienta útil en la gestión de enfermedades complejas como el infarto agudo de miocardio, la enfermedad coronaria multivaso y la disfunción ventricular severa— su uso clínico debe ir acompañado de gobernanza ética, juicio clínico situado, y deliberación compartida, particularmente en entornos como el venezolano, marcados por la incertidumbre, la vulnerabilidad y la fragmentación del sistema de salud.

La inteligencia artificial puede ser un potente aliado del intervencionista, pero si se despliega sin supervisión, sin regulación ética y sin mediación humana, puede transformarse en una fuente silenciosa de daño clínico, emocional y moral.

Iatrogenia algorítmica: definición, riesgos y expresión clínica

En el ejercicio médico tradicional, la iatrogenia refiere a todo daño no intencionado causado por intervenciones clínicas. Con la creciente integración de inteligencia artificial (IA) en medicina, ha surgido una nueva forma: la iatrogenia algorítmica, entendida como el perjuicio generado directa o indirectamente por decisiones clínicas automatizadas, recomendaciones algorítmicas o interpretaciones no mediadas de sistemas de IA, sin juicio clínico humano que supervise, module o contextualice (1,2).

Esta iatrogenia no siempre se manifiesta como error técnico o mal procedimiento, sino como una consecuencia no prevista de una intervención tecnológica mal comunicada, mal entendida o desproporcionada al contexto clínico. En cardiología intervencionista, puede abarcar desde indicaciones inapropiadas de procedimientos, hasta omisiones críticas o reacciones emocionales graves desencadenadas por predicciones automatizadas sin acompañamiento (3,4).

Los principales riesgos generales incluyen:

- Descontextualización del dato clínico por uso de modelos entrenados en poblaciones distintas.

- Automatización sin deliberación, que desplaza el juicio clínico.

- Sesgos algorítmicos que amplifican inequidades.

- Pérdida de autonomía del paciente y del médico.

- Dilución de la responsabilidad ética o legal ante errores de la IA (5,6).

El caso clínico como expresión de iatrogenia algorítmica emocional

El caso presentado en la introducción ilustra una forma concreta de iatrogenia algorítmica indirecta y emocional, en la que un paciente con cardiopatía isquémica severa consulta una aplicación de IA no validada, que emite una sentencia alarmante: “riesgo inminente de muerte súbita”. El mensaje, recibido sin mediación profesional ni explicación contextual, desencadena una crisis de ansiedad, con síntomas neurovegetativos, arritmia ventricular y descompensación clínica.

Desde una perspectiva bioética, el caso compromete seriamente el principio de no maleficencia, al provocar un daño psíquico y clínico evitable. También vulnera la autonomía, ya que el paciente tomó una decisión —consultar la IA— sin la comprensión adecuada de los límites del sistema. Finalmente, muestra cómo la responsabilidad se desvanece, pues no hay figura institucional que asuma el impacto causado por esa intervención tecnológica informal (1,7).

Este episodio es paradigmático porque no hubo error médico, ni falla técnica, ni acción invasiva. El daño fue generado por la intervención de un sistema sin contexto, sin supervisión y sin responsabilidad, que desplazó el juicio clínico y activó mecanismos emocionales en un paciente vulnerable. En contextos como el venezolano, donde el acceso a segundas opiniones está limitado, este tipo de escenarios podría volverse más frecuente.

Por ello, la iatrogenia algorítmica no debe considerarse una rareza, sino un riesgo emergente que exige anticipación, regulación, contención emocional y formación ética tanto para médicos como para pacientes.

¿Qué entendemos por iatrogenia algorítmica?

Proponemos el término “iatrogenia algorítmica” para designar una forma emergente de daño clínico, emocional o estructural provocada por el uso inadecuado, no contextualizado o no supervisado de herramientas de inteligencia artificial o sistemas algorítmicos en medicina. Esta iatrogenia no es causada directamente por errores humanos clásicos ni por fallas técnicas tradicionales, sino por decisiones automatizadas que desplazan el juicio clínico, reducen la deliberación médica y afectan la autonomía del paciente sin una mediación profesional adecuada.

Este concepto incorpora:

- Daños por acción (por ejemplo, sobreindicación de procedimientos invasivos por una IA mal entrenada).

- Daños por omisión (como la no detección de patrones clínicos en pacientes subrepresentados).

- Daños emocionales o relacionales (como la ansiedad inducida por predicciones alarmantes sin acompañamiento humano).

- Responsabilidad difusa (por decisiones tomadas por algoritmos de caja negra sin trazabilidad ética ni legal clara).

La iatrogenia algorítmica constituye una categoría bioética nueva que exige marcos deliberativos, gobernanza clínica y alfabetización digital tanto para profesionales como para pacientes, especialmente en contextos vulnerables como el venezolano.

Principios bioéticos implicados

La inteligencia artificial aplicada a la medicina, especialmente en áreas de alta complejidad como la cardiología intervencionista, no puede implementarse sin un marco bioético robusto. El caso clínico presentado demuestra que el uso no regulado o no mediado de herramientas algorítmicas puede vulnerar principios fundamentales de la bioética clínica, incluso sin que exista una intervención invasiva o un error técnico clásico.

4.1. No maleficencia

Este principio exige no causar daño intencional o evitable. En el caso analizado, la alerta emitida por un sistema automatizado —fuera del entorno clínico, sin supervisión y sin sensibilidad comunicacional— provocó un evento emocional y fisiológico adverso. El daño fue real, aunque indirecto, y pudo haberse evitado si la herramienta hubiera sido utilizada en el contexto de una consulta médica estructurada (1,2).

4.2. Autonomía

La autonomía del paciente fue socavada por una falsa sensación de control informativo. Al consultar la IA sin comprender su funcionamiento ni su validez clínica, el paciente tomó decisiones bajo un marco de ignorancia algorítmica, no de consentimiento informado. La autonomía bioética requiere comprensión, no solo acceso a información (3).

4.3. Justicia

El acceso a herramientas no validadas como sustituto de la consulta profesional responde a un entorno desigual, donde no todos los pacientes pueden pagar una segunda opinión especializada. Esto plantea un dilema de justicia distributiva: ¿la IA amplía el acceso o profundiza las brechas cuando no hay acompañamiento humano ni validación institucional? (4).

4.4. Responsabilidad

La ética médica tradicional reconoce la responsabilidad del acto clínico. Con la IA, esta responsabilidad se vuelve difusa: ¿quién responde por el daño causado por una alerta automatizada? ¿El desarrollador del algoritmo, la plataforma que lo aloja, el usuario, el médico que luego trata las consecuencias? Esta falta de imputabilidad concreta representa un vacío ético y legal urgente de abordar (5,6).

4.5. Profesionalismo y deliberación

Más allá de los principios clásicos, este caso interpela al profesionalismo médico contemporáneo. ¿Cuál es el rol del médico frente a sistemas que “saben más” en términos de predicción, pero no en términos de compasión, prudencia ni historia personal del paciente? El profesionalismo exige no abdicar del juicio clínico frente a la máquina, sino integrarlo con deliberación ética (7).

Propuestas prácticas y recomendaciones institucionales

Frente al avance acelerado de la inteligencia artificial (IA) en la práctica médica y los riesgos bioéticos evidenciados en el caso clínico presentado, resulta urgente proponer acciones concretas para mitigar la iatrogenia algorítmica, especialmente en entornos frágiles como el sistema de salud venezolano.

Alfabetización digital y bioética del paciente

Es indispensable desarrollar estrategias de educación sanitaria y digital para los pacientes y sus familiares, especialmente en el uso de herramientas tecnológicas no reguladas. Comprender que un algoritmo no equivale a una segunda opinión médica requiere un cambio cultural que promueva la deliberación y no la dependencia tecnológica acrítica.

Supervisión médica obligatoria en entornos asistidos por IA

Toda herramienta de IA aplicada a decisiones clínicas debe estar supervisada por un profesional de la salud capacitado, quien actúe como filtro contextual, garante del juicio prudente y mediador entre los datos y la dignidad del paciente. Esto incluye desde plataformas de electrocardiografía automatizada hasta asistentes diagnósticos predictivos.

Evaluación y validación contextual de algoritmos

Antes de implementar IA en hospitales, clínicas o consultas, deben establecerse criterios de validación local: ¿fue entrenado el algoritmo en poblaciones similares?, ¿cuál es su sensibilidad y especificidad en pacientes venezolanos?, ¿cómo se comporta en condiciones de baja conectividad o recursos?

Protocolos institucionales ante herramientas algorítmicas

Se recomienda que los centros asistenciales desarrollen protocolos claros de uso de IA, incluyendo:

- Criterios para su adopción.

- Límites de decisión automatizada.

- Mecanismos de revisión médica obligatoria.

- Estrategias de comunicación del riesgo al paciente.

Esto no solo protege a los usuarios, sino también al personal médico, evitando desplazamientos de responsabilidad o conflictos legales posteriores.

Comités de bioética activos y formación continua

Los comités de bioética deben anticiparse a estos desafíos tecnológicos, y no llegar solo cuando ocurren eventos adversos. Su rol debe incluir la evaluación de nuevos sistemas, el acompañamiento en la toma de decisiones clínicas complejas, y la formación continua del personal médico en ética de la inteligencia artificial.

Articulación con universidades e instituciones científicas

La IA en salud no puede ser introducida como una moda empresarial. Es necesario establecer alianzas entre clínicas, universidades, sociedades científicas y entes regulatorios para construir una IA médica situada, ética, transparente y formativa, que fortalezca el acto médico y no lo suplante.

En resumen, la inteligencia artificial puede ser una aliada valiosa en la cardiología intervencionista, pero solo si su implementación está guiada por criterios clínicos, éticos y contextuales claros. De lo contrario, corremos el riesgo de reemplazar la incertidumbre del juicio prudente por la certeza deshumanizada del algoritmo.

Conclusión

La incorporación de la inteligencia artificial en cardiología intervencionista representa un avance potencialmente transformador, especialmente en contextos de alta complejidad clínica. No obstante, el caso analizado demuestra que cuando estas tecnologías se emplean sin supervisión, sin validación contextual y sin acompañamiento profesional, pueden convertirse en fuentes de daño emocional, clínico y ético: es lo que denominamos iatrogenia algorítmica.

El episodio documentado —un paciente vulnerable expuesto a una predicción automatizada sin mediación clínica— evidencia que el problema no radica en la IA per se, sino en su despliegue acrítico, opaco y desregulado. Esto plantea interrogantes fundamentales sobre la relación entre el juicio médico y la lógica algorítmica, la autonomía del paciente frente a sistemas de caja negra, y la responsabilidad profesional en un entorno asistencial cada vez más mediado por tecnología.

Frente a ello, proponemos una implementación ética, prudente y situada de la inteligencia artificial en medicina, que no desplace la figura del médico ni trivialice la complejidad humana del acto clínico. Esto implica reforzar la alfabetización digital sanitaria, establecer protocolos claros de uso, fomentar la deliberación bioética institucional y consolidar marcos normativos adaptados a nuestra realidad venezolana.

Porque en medicina, la tecnología no es fin en sí misma, sino medio para proteger la vida, aliviar el sufrimiento y dignificar al paciente. Y esa tarea sigue siendo, indelegablemente, humana.

Referencias

- Núñez Medina TJ. Inteligencia artificial, decisión médica y muerte súbita: un dilema bioético en cardiología intervencionista [Internet]. Instituto Educardio; 2024 [citado 2025 may 7]. Disponible en: https://institutoeducardio.org/inteligencia-artificial-decision-medica-y-muerte-subita-un-dilema-bioetico-en-cardiologia-intervencionista/

- Niroda K, Drudi C, Byers J, et al. Artificial Intelligence in Cardiology: Insights From a Multidisciplinary Perspective. J Soc Cardiovasc Angiogr Interv. 2025;4:102612. https://doi.org/10.1016/j.jscai.2025.102612

- Lopez-Jimenez F, Attia ZI, Kapa S. Artificial intelligence in cardiovascular medicine: is it ready for primetime? Expert Rev Cardiovasc Ther. 2021;19(8):653–655. https://doi.org/10.1080/14779072.2021.1962882

- Chatzizisis YS, Edelman ER. Revolutionizing Cardiovascular Interventions With Artificial Intelligence. J Soc Cardiovasc Angiogr Interv. 2025;4:102580. https://doi.org/10.1016/j.jscai.2025.102580

- Norori N, Hu Q, Aellen FM, et al. Addressing bias in big data and AI for health care: a call for open science. Patterns (N Y). 2021;2(10):100347. https://doi.org/10.1016/j.patter.2021.100347

- Lata K, Rooney C, Tukaye D, et al. Governing the Unbound: SCAI’s Role in the Future of Artificial Intelligence. J Soc Cardiovasc Angiogr Interv. 2025;4:102517. https://doi.org/10.1016/j.jscai.2024.102517

- Chin MH, Afsar-Manesh N, Bierman AS, et al. Guiding principles to address the impact of algorithm bias on racial and ethnic disparities in health and health care. JAMA Netw Open. 2023;6(12):e2345050. https://doi.org/10.1001/jamanetworkopen.2023.45050

- Beauchamp TL, Childress JF. Principles of Biomedical Ethics. 8th ed. Oxford University Press; 2019.

- Samant S, Bakhos JJ, Wu W, et al. Artificial intelligence, computational simulations, and extended reality in cardiovascular interventions. JACC Cardiovasc Interv. 2023;16(20):2479–2497. https://doi.org/10.1016/j.jcin.2023.07.022